概要

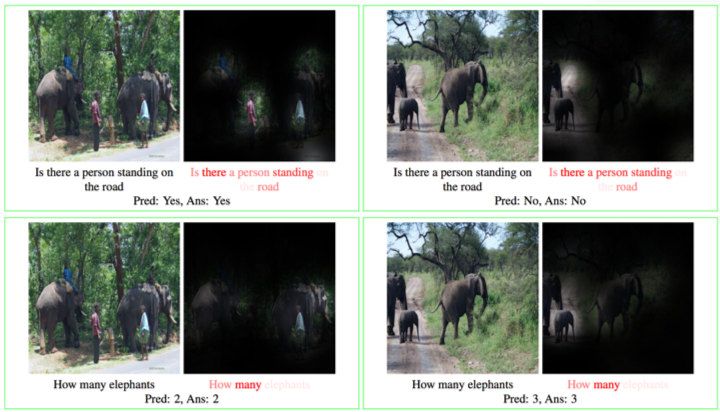

画像理解のために,自然言語を用いた方法論についても幅広く研究しています.例えば,画像と質問文をニューラルネットワークに与え,質問に対する適切な答えを返答するタスクであるVQAについて研究を行っています.VQAでは,言語と画像間の関係性を捉えることが重要とされていますが,我々の研究では言語と画像間の関係を良好に捉える方法を開発しました(下図).

また,VQAだけでなく,画像付き対話(visual dialog)や自然言語を用いたナビゲーション,画像記述(image captioning)などvision and languageに関して幅広く研究を行っています.

発表文献

Van-Quang Nguyen, Masanori Suganuma, Takayuki Okatani: Look Wide and Interpret Twice: Improving Performance on Interactive Instruction-following Tasks, International Joint Conference on Artificial Intelligence (IJCAI), 2021 [PDF]

Van-Quang Nguyen, Masanori Suganuma, Takayuki Okatani: Efficient Attention Mechanism for Visual Dialog that can Handle All the Interactions between Multiple Inputs, European Conference on Computer Vision (ECCV), 2020 [PDF]

Duy-Kien Nguyen and Takayuki Okatani, Multi-task Learning of Hierarchical Vision-Language Representation, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019 [PDF]

Duy-Kien Nguyen and Takayuki Okatani, Improved Fusion of Visual and Language Representations by Dense Symmetric Coattention for Visual Question Answering, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018 [PDF]